Quero começar este post mencionando que não usei o ChatGPT, mas, sim, minha esposa Gisele que corrige 90% dos meus textos. Logo, os 10% publicados na internet com erros foram os que ela não corrigiu!

Voltando ao ponto focal, eu acreditava que a Visão Neuromórfica seria o futuro da Visão Computacional. Aparentemente eu estava enganado, pois a arquitetura Transformers está derivando em tecnologia que será capaz de ler nossos lábios durante conversas nas ruas em imagens de câmeras públicas de monitoramento.

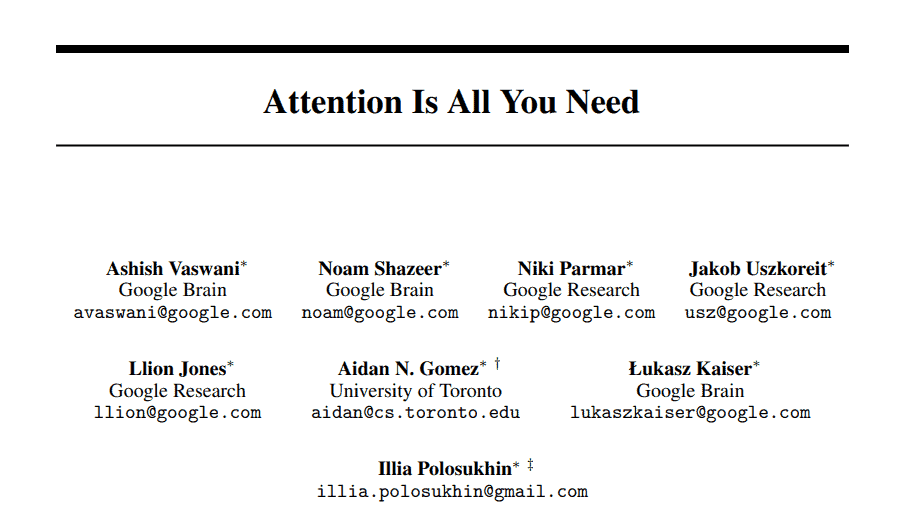

Essa minha afirmação deve-se a um paper, publicado em 2017, chamado “Attention Is All You Need” [1], que apresentava um novo modelo de rede neural focado no processamento de Linguagem Natural, hoje conhecido como Transformers, que deu origem ao ChatGPT da openAI (seq2seq).

Hoje estamos com uma avalanche informacional no setor de redes neurais. O assunto da moda chamada Transformers é a primeira revolução de mais dois assuntos que merecem atenção e ficarão para os próximos posts.

Esse novo modelo foi focado em NLP (Processamento de Linguagem Natural). Em 2020, terminei os testes com o GPT-3 e postei aqui no assunto nerd. O que mais chamou a minha atenção nessa tecnologia foi o Mecanismo de Atenção. Essa técnica mudou tudo, até minha maneira de ver os meus trabalhos técnicos. O conceito foca na informação de dados ruidosos, resolvendo, assim, o gargalo representativo baseado no escore de atenção.

Não vou perder tempo com o Chat GPT, pois a mídia já fez isso muito bem. Então, podemos dizer que o esforço cognitivo do GPT-3 ou 4 é a maneira diferenciada de processar/interpretar o contexto.

Em 2021 outro paper [2] surgiu com uma nova proposta de rede neural, focada em melhorar a forma como as máquinas enxergam. A Vision Transformer, ou ViT, é uma arquitetura muito semelhante ao modelo Transformers proposto em 2017, com pequenas alterações para processar imagens em vez de textos.

Até aqui, as redes neurais convolucionais foram o estado da arte em visão computacional. O seu processamento é baseado nos kernels convolucionais para reconhecer as características dos objetos. É uma saga treinar um CNN. O ViT tem a proposta de não imitar o conceito do Transformers, pois o conceito de Mecanismo de Atenção para cada pixel seria inviável em termos de custo computacional. Aí veio a genialidade do paper: o modelo divide a imagem em unidades quadradas (denominadas tokens), cujo padrão é 16×16, aplicando, assim, o Self-Attention em cada parte da imagem. Com isso, a velocidade é impressionante, pois o ViT varre a imagem com 90% de precisão.

Nos testes de processamento de imagem em 14/03, uma versão do ViT assumiu o primeiro lugar; o segundo lugar foi para um modelo que combinou CNN com Transformers. Para entenderem o contexto, as melhores CNNs de longa data não chegaram perto dessa nova abordagem. Agora, em 16/04/2023, os modelos Transformers+CNN atingiram o primeiro lugar.